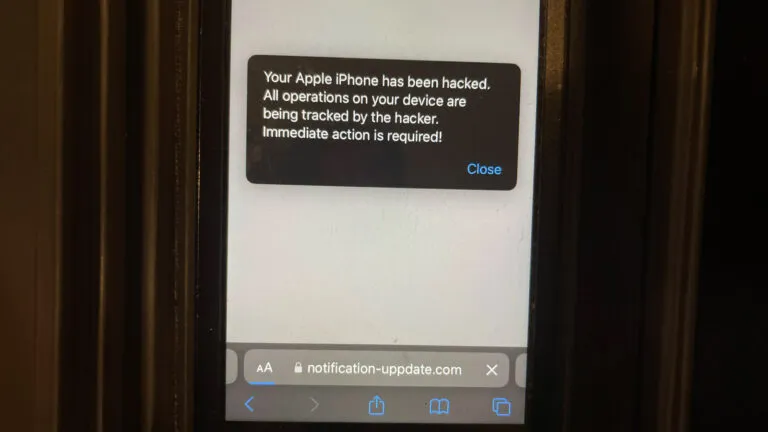

En Microsoft inspirar 2023 Conferencia, sucedió algo emocionante. Microsoft se asocia con Meta para formar una asociación de IA con Llama 2.

Hoy en Microsoft Inspire, Meta y Microsoft anunciaron el soporte para la familia Llama 2 de modelos de lenguaje grande (LLM) en Azure y Windows. Llama 2 está diseñado para empoderar a los desarrolladores y organizaciones para crear herramientas y experiencias generativas impulsadas por IA. Meta y Microsoft comparten el compromiso de democratizar la IA y sus beneficios y estamos encantados de que Meta adopte un enfoque abierto con Llama 2. open and borders y estamos encantados de ser el socio preferido de Meta en el lanzamiento comercial de su nueva versión de Llama 2. clientes.

microsoft

Tiene sentido, porque el primer día de la conferencia estuvo dedicado a la IA. Microsoft ha anunciado muchas cosas relacionadas con la IA fuera de su asociación Meta AI. Servicio Open AI de Azure ahora está disponible en Asia después de su lanzamiento reciente en América del Norte y Europa.

Empresa de chat de Bing También se anunció, y es la versión de Bing AI pero para el trabajo. La herramienta ya está disponible en versión preliminar. Y, Programa de socios en la nube de Microsoft obtiene una actualización de IA. Ahora puede usar la IA para desarrollar su plan de negocios o estrategia de marketing mientras la usa para crear una cartera.

Entonces, cuando se trata de IA, Microsoft ha estado a la vanguardia desde el principio. Y ahora, la asociación del gigante tecnológico con sede en Redmond con Meta puede ser la próxima gran novedad en el mundo de la IA.

Descubre Llama 2 AI – Microsoft x Meta Asociación

Como se mencionó anteriormente, Llama 2 permite a los desarrolladores y organizaciones crear herramientas y experiencias generativas de IA.

Podrá refinar e implementar los modelos Llama 2 en configuraciones 7B, 13B y 70B de manera fácil y segura en Azure.

Además, debes saber que Llama estará optimizado para ejecutarse localmente en Windows. Y si usted es un desarrollador que trabaja en Windows, podrá usar Llama dirigiéndose al proveedor de tiempo de ejecución de DirectML a través de ONNX Runtime.

Los desarrolladores de Windows también podrán crear fácilmente nuevas experiencias usando Llama 2, accesible a través de GitHub Repo. Con Windows Subsystem para Linux y GPU de alto rendimiento, puede ajustar los LLM para satisfacer sus necesidades específicas directamente en sus PC con Windows.

¿Qué opinas de esta asociación? Háganos saber en la sección de comentarios.